2022.1.4|SEO対策

「robots.txt」ってなに?「robots.txt」を設定することでSEOには影響する?

robots.txtを配置することで、Webサイトの重要なコンテンツとそうでないコンテンツを、検索エンジンのクローラーに伝えることができます。

robots.txtは、CMSを活用しているWebサイトや大規模なWebサイトを運営しているケースに配置させることが多いです。robots.txtを配置することでSEOにどんな影響を与えることができるのか。

今回は、「robots.txt」の仕組みと設定方法、SEO効果について解説します。

本記事の内容

robots.txtとは?

robots.txtとは、Webサイトの検索エンジンクローラーに巡回されたくない特定のコンテンツページを制御する為のテキストファイルです。

Webサイトのコンテンツには検索エンジンに上位表示させる必要のないコンテンツページや検索結果に表示をさせたくないコンテンツページが含まれています。

そのようなコンテンツページをrobots.txtを設定してクローラーの巡回を制御することができます。

robots.txtを設定しコンテンツページのクロールを制御することもできますが、ディレクトリの設定を行う事でディレクトリは以下を制御することもできます。

また、クロール制御の設定だけでなく、sitemap.xmlのような効率良くクローラーに巡回してもらいたいコンテンツページの場所をクローラーに伝えることもできます。

検索エンジンに、伝えたくないコンテンツページと伝えたいコンテンツページを設定することでWebサイトをより最適化できます。

robots.txtの4つの役割

クローラーはWebサイトの情報を収集するために定期的にWebページやコンテンツを訪問します。

robots.txtを設定して出来る4つの役割をご紹介します。

①クローラーに巡回の許可・拒否をするURLを伝える

②Google検索結果にメディアファイルの巡回を拒否するURLを伝える

③会員情報やログインが必要なURLを伝える

④サイトマップファイルのURLを伝える

クロールの最適化を実施することで、検索結果で上位表示させたいページを意識的に伝えられるため、SEO対策としてはひとつの施策として考えることもできます。

robots.txtはSEOには影響するのか

robots.txtは、「XMLサイトマップ」と同じように、検索ロボットにWebサイトを巡回させて情報を取得しています。検索クローラーは、robots.txtを一番最初に読み込み、そのWebサイト内のクロールすべきページとすべきでないページを判断します。

robots.txtを設定することで、直接検索順位に影響するものではありませんが、robots.txtは、「XMLサイトマップ」と同じように、SEOに大きく影響します。

また、内部リンクがないページや大規模なWebサイトの場合、Googleの評価が「検出-インデックス未登録」や「クロール済み-インデックス未登録」になってしまうことがあります。

検索エンジンクローラーでクローリングされれば、必ずしも検索エンジンのデータベースに登録される、というわけではありません。内部リンクがないページや大規模なWebサイトは、検索エンジンがURLを発見できない場合があります。

本来あるべきページが検索エンジンのデータベースに登録されていないとなると、SEOに影響がでてしまいます。

このような場合に、robots.txtを設定することでクローリングの最適化に繋がりクローラビリティを高めることができます。

SEO対策を施策しても、検索エンジンにインデックスしてもらえなければ意味がありません。

robots.txtを正しく設定することで、重要度の高いコンテンツが優先的にクロールされ、サイト全体のSEOにも大きく影響し、検索エンジンにも良い評価を与えることができます。

robots.txtの設定方法

robots.txtの書き方と設定方法をご説明します。

1.robots.txtファイルの作成

テキストエディタを使用し、ファイル名「robots.txt」を作成してます。

ファイル名が異なってしまうとクローラーが認識できない為、必ず間違えないように拡張子まで確認します。

2.robots.txtに記述

記述する内容は、主に「User-agent」「Disallow」「Allow」「Sitemap」の4つの要素で構成されます。

User-Agent:制御したいクローラーの種類を指定

Disallow :クローラーの巡回を拒否するページを指定

Allow :クローラーの巡回を受け入れるページを指定

Sitemap :クローラーのためのサイトマップの場所を指定

robots.txt基本要素

User-agent:

Disallow:

Allow:

Sitemap:「User-agent」では、制御したいクローラーの種類を指定します。

「*(アスタリスク)」で設定した場合は、全てのクローラーを対象にします。

| クローラー | ユーザーエージェント |

|---|---|

| 全部のクローラー | * |

| Google(パソコン用) | Googlebot |

| Google(スマートフォン用) | Googlebot |

| Googlebot(画像用) | Googlebot-image |

| Googlebot(動画用) | Googlebot-Video |

| Googlebot(ニュース用) | Googlebot-News |

| Yahoo!検索エンジン | Yahoo!Slurp |

| Yahoo!Japan検索エンジン | Y!J |

| Baidu検索エンジン | Baidu |

| Twitterbot | |

| facebookexternalhit |

全部のクローラー

User-agent: *「Disallow」では、クローラーの巡回を拒否するページを指定します。

記述したディレクトリやページは検索エンジンがクロールしなくなります。

サイト全体をクロール拒否

Disallow: /ディレクトリ単位でクロール拒否

Disallow: /blog/ページ単位でクロール拒否

Disallow: /blog/web_design.html「Allow」では、クローラーの巡回を受け入れるページを指定します。

記述したディレクトリやページは検索エンジンがクロールするようになります。

※クローラーはデフォルトでサイト内全てのページにクロールするように設定されている為、必要な場合以外は設定する必要はありません。

Disallowでクロール拒否しつつ、一部のファイルを許可

Disallow: /login/

Allow: /login/main/「Sitemap」では、クローラーのためのサイトマップの場所を指定します。

「sitemap.xml」の場所をrobots.txtに記載することをGoogleは推奨しています。必ず「sitemap.xml」の場所を記述しましょう。

sitemap.xmlを指定

Sitemap : https://ドメイン.jp/sitemap.xml3.robots.txtをサーバーにアップロード

robots.txtを作成したら、サーバーにアクセスし、ドメイン直下にアップロードします。

※ドメイン直下以外のディレクトリに配置しても効果は発揮しません。

〇 https://kingsite.jp/robots.txt

✕ https://kingsite.jp/blog/robots.txt

robots.txt記述例

各要素の記述をまとめた例を紹介します。

基本設定

User-agent: *

Disallow: /login/

Allow:

Sitemap: https://kingsite.jp/sitemap.xmlWordPress設定

User-agent: *

Disallow: /wp-admin/

Allow:

Sitemap: https://kingsite.jp/sitemap.xml

Sitemap: https://kingsite.jp/sitemap.rssMovable Type設定

User-agent: *

Disallow: /mt/

Allow:

Sitemap: https://kingsite.jp/sitemap.xml

Sitemap: https://kingsite.jp/sitemap.rssrobots.txt記述内容の確認方法

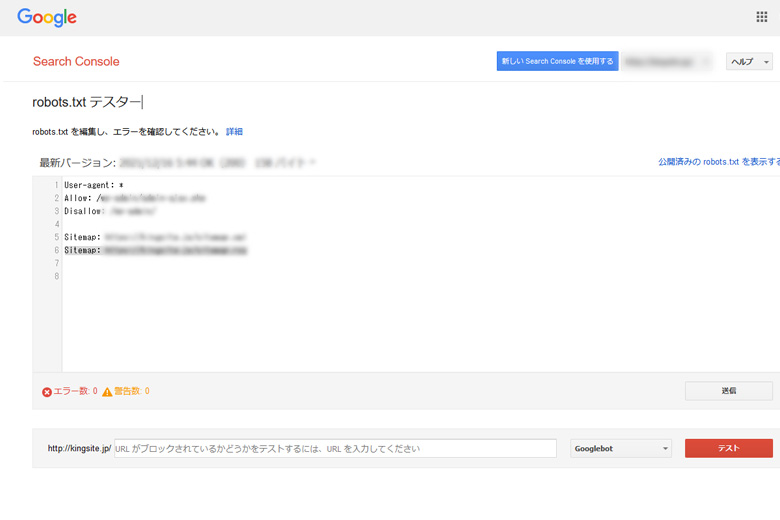

記述したrobots.txtは、SearchConsole(グーグルコンソール)のツールで検証ができます。SearchConsole(グーグルコンソール)の登録を行いグインします。

「プロバティを追加」をクリックしてURLを入力してください。

SearchConsole(グーグルコンソール)

まとめ

robots.txtを配置することで直接検索順位に影響するものではありませんが、SEOには大きく影響があります。設定することはそれほど難しい作業がありませんので、実装するのは簡単です。

良質なコンテンツを目指して内部リンクや外部リンクを見直す要素のひとつですね。robots.txtを実装することで検索上位表示に少しでも影響するのであれば、必ず設定した方が良いと思います。